编辑|LSLS

出品 | 本站

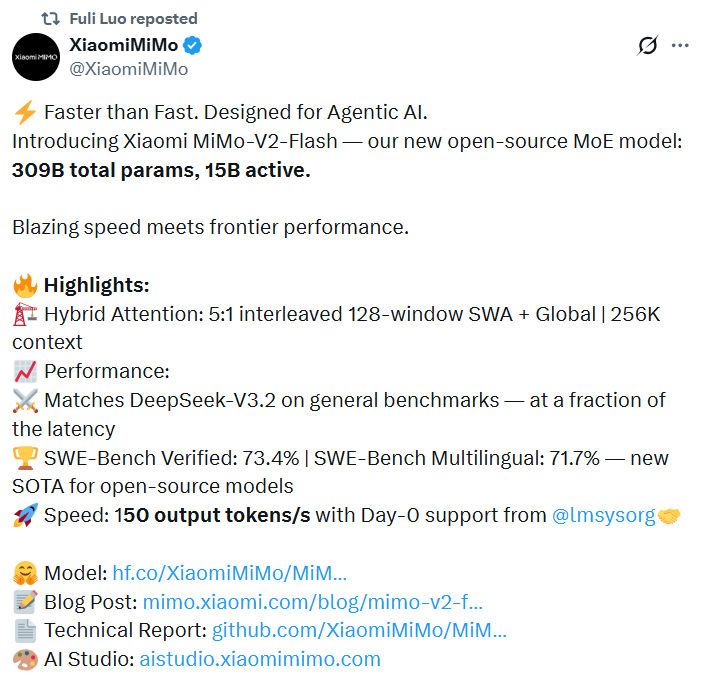

中国开源模型再次迎来一位重磅选手:就在刚刚,小米正式发布并开源新模型 MiMo-V2-Flash。

在今日上午的小米“人车家全生态”合作伙伴大会上,Xiaomi MiMo大模型负责人罗福莉也首秀并介绍了这款最新发布的大模型。

图片

图片

MiMo-V2-Flash 采用专家混合架构 (MoE),总参数 3090 亿,活跃参数 150 亿,主打高速推理与智能体工作流,性能媲美 DeepSeek-V3.2、Kimi-K2-Thinking 等头部开源模型。

图片

图片

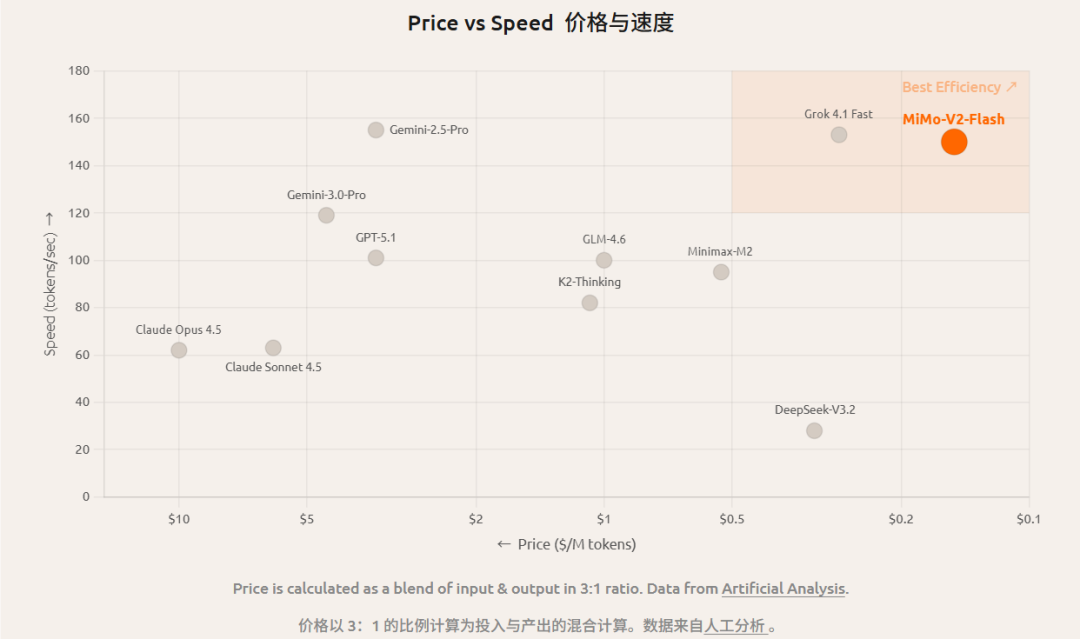

最炸裂的是MiMo-V2-Flash的推理速度,达到了 150 tokens/秒,成本压到了每百万 token 输入 0.1 美元、输出 0.3 美元,主打一个超绝性价比。

图片

图片

MiMo-V2-Flash专为推理、编码和智能体场景构建,各式各样的网页开发也不在话下,比如一个炫酷的豪华圣诞树3D交互网页:

图片

图片

此外,MiMo-V2-Flash 采用 MIT 开源协议,基础版权重及技术报告均已开源。

跻身开源模型前两名,编程能力逼近GPT-5-High

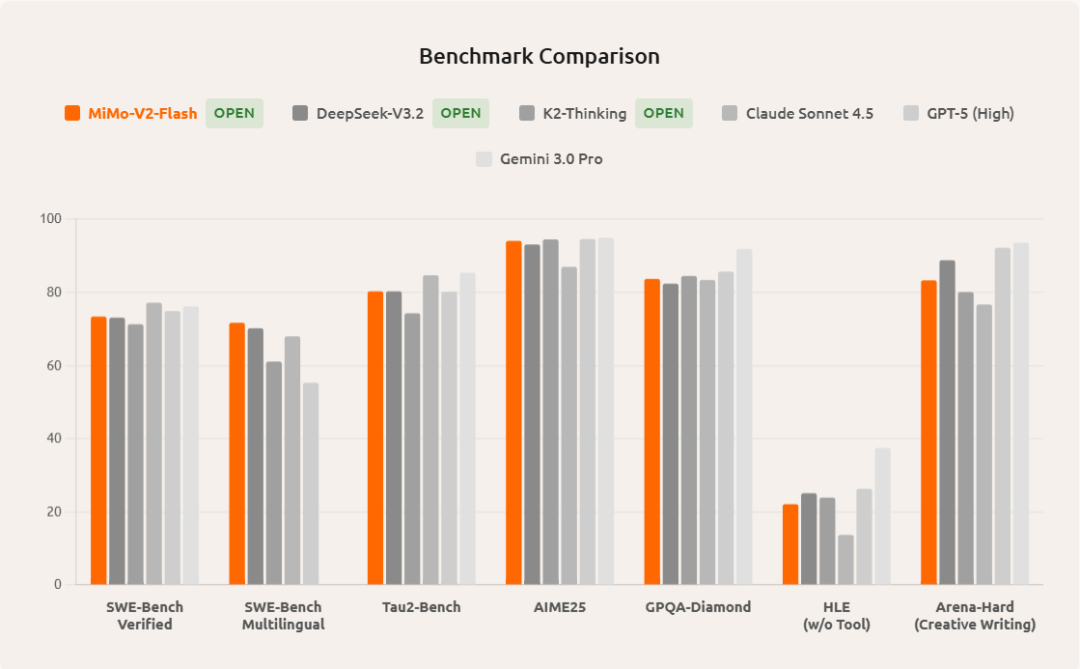

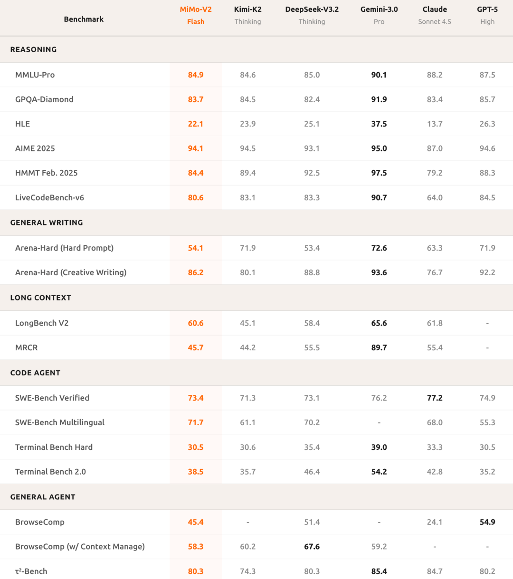

先来看看跑分情况,MiMo-V2-Flash 在多项主流基准测试中表现突出,媲美K2-Thinking和DeepSeek-V3.2。

图片

图片

在 AIME 2025 数学竞赛 和 GPQA-Diamond 科学知识测试这类高难度任务中,它都稳稳排进开源模型前两名,推理能力已经站到第一梯队。

图片

图片

它的编程成绩也让人眼前一亮。在被公认为“最接近真实世界开发”的 SWE-bench Verified 测试中,MiMo-V2-Flash 拿下 73.4% 的通过率,直接刷新开源模型纪录,整体表现已经逼近 GPT-5-High。要知道,这个测试不是写小脚本,而是让模型去修真实项目里的 bug。73.4% 的成功率,意味着它已经能解决绝大多数实际编程问题。

放到多语言场景,MiMo-V2-Flash 同样不虚。在 SWE-Bench Multilingual 中,它的解题成功率达到 71.7%,说明不管是 Python、Java 还是其他语言,都具备稳定的工程能力。

再看智能体任务,这也是它的重点优势之一。

在 τ²-Bench 中,MiMo-V2-Flash 在通信、零售、航空三类任务里分别拿到 95.3、79.5 和 66.0 的高分;在 BrowseComp 搜索代理测试中,基础得分为 45.4,开启上下文管理的情况下,成绩直接跃升到 58.3。这说明它不仅能“回答问题”,还能在多轮交互中持续理解目标、做决策、完成任务。

此外,它的写作和表达质量也接近顶级闭源模型水准。这是MiMO-V2-Flash即兴创作的小说,看起来笔触还是相当细腻的:

图片

图片

三项黑科技:SWA、轻量级MTP和后训练MOPD

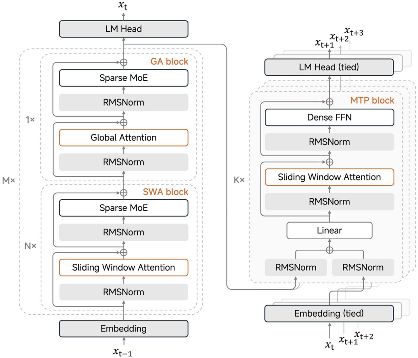

MiMo-V2-Flash 能做到推理性能的极致性价比,其核心来自一系列专门为高吞吐推理设计的架构创新。

- 混合滑动窗口注意力机制

MiMo-V2-Flash 采用了一种 1:5 的混合注意力设计:少量全局注意力,搭配大量 滑动窗口注意力(Sliding Window Attention,SWA)。大量实验结果表明,SWA 结构简单、效率高、易落地,在通用任务、长上下文处理以及复杂推理任务上,整体表现都优于线性注意力。

图片

图片

更重要的是,SWA 使用固定大小的 KV Cache,这意味着它可以非常顺滑地接入现有的训练和推理基础设施,不需要大规模重构工程体系。

罗福莉还指出:窗口大小 128 是关键数值。实验证明,盲目扩大窗口(如增至 512)反而会导致性能下降。同时她强调,在实施该机制时,sink values 是维持性能的关键,绝不可省略。

图片

图片

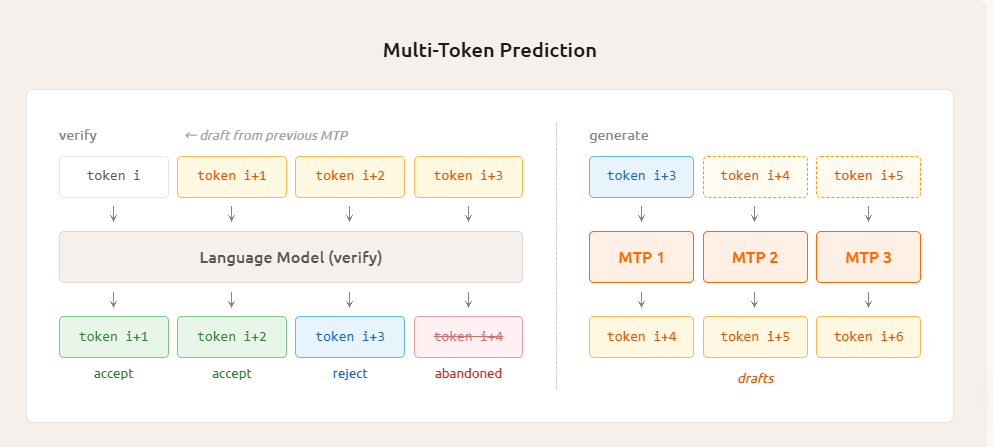

- 轻量级多 Token 预测 (MTP)

传统大模型解码,本质上是一个强内存受限的过程:算力并没有完全吃满,瓶颈往往卡在 KV Cache 的读写上。

而MTP让模型一次性预测多个候选 token、,然后由主模型并行验证这些 token 是否可接受。这样一来,FFN 和 Attention 的算术强度都被同时拉高,却不增加 KV Cache 的 I/O 压力,真正实现了 token 级并行。

在 MiMo-V2-Flash 中,MTP 不是外挂模块,而是原生能力,直接作为自推测解码的草稿模型使用,带来了实打实的部署级加速效果。

为了避免 MTP 本身变成新的性能瓶颈,MiMo-V2-Flash 对 MTP 模块做了非常克制的设计:

- 使用 Dense FFN(而非 MoE),控制参数规模

- 使用 SWA 而非 GA,进一步降低 KV Cache 和注意力计算成本

- 模块整体保持轻量,但不牺牲预测质量

图片

图片

结果也很漂亮。据罗福莉介绍,在三层 MTP 设置下,他们观察到平均接受长度超过 3,编码任务速度提升约 2.5 倍。它有效解决了小批量 On-Policy 强化学习中「长尾样本」带来的 GPU 空闲时间浪费问题。

图片

图片

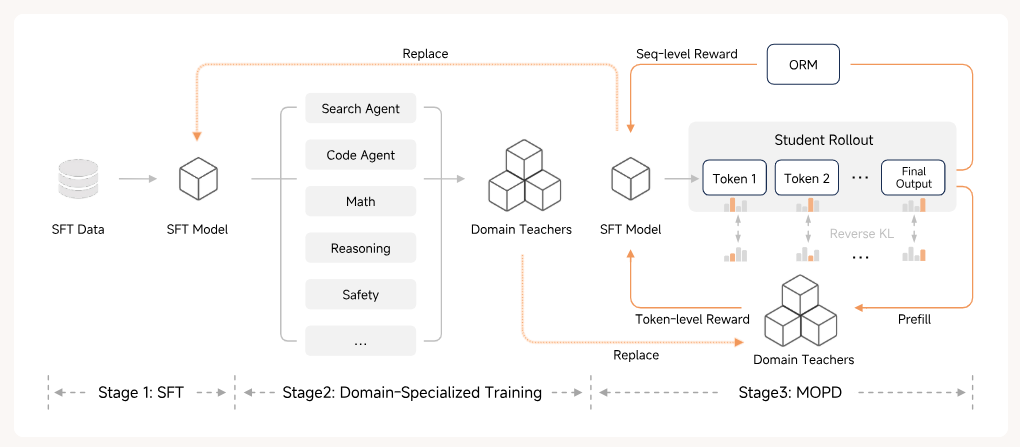

- MOPD:一种全新的后训练范式

在后训练阶段,小米还整了个新活:多教师在线策略蒸馏(MOPD)。

MOPD 的核心,是一种高效的 on-policy 学习机制。具体来说,研究者先通过 SFT / RL 训练出多个领域专家级教师模型,随后让学生模型直接从自身策略分布中进行采样(rollout),并利用来自多个教师模型提供的、细粒度到 token 级别的密集奖励信号进行优化。

图片

图片

最惊人的是效率提升,MOPD 只需要传统方法 1/50 的算力,就能让学生模型达到教师性能峰值。这意味着小米能用更少的资源,更快地迭代模型。

罗福莉表示,这个方法借鉴于Thinking Machine,将多个强化学习模型进行融合,结果带来了惊人的效率提升。这为构建一个自我强化循环系统奠定了基础,学生模型可以逐步进化,最终成为更强的教师模型。

图片

图片

属于开源模型的「小米时刻」,来了

在今天上午的小米“人车家全生态”合作伙伴大会上,罗福莉表示:

“2020年我刚进入这行的时候,中国开源模型和世界顶尖闭源模型的代际差距,我认为还有3年;但到了今天,这个差距只有数月。”

这无疑是一句令人热血沸腾的话,意味着中国开源模型与顶尖闭源的差距在不断缩小,且性价比在不断提升。此次MiMo-V2-Flash的 150 tokens/秒的推理速度,每百万 token 输入 0.1 美元、输出 0.3 美元的成本,也让我们目睹了中国开源模型能把性价比压榨到多么极致的地步。

在最新的罗永浩播客中,MiniMax 创始人闫俊杰也公开表示:现在中国开源模型的研发成本只有世界顶尖模型的1/10,但性能差距仅不到5%。

小米的野心不止于“人车家”。罗福莉在社交媒体上披露了更多信息:MiMo-V2-Flash的发布只是小米AGI路线图的第二步。这背后暗示了小米在AI赛道上全面发力的决心。

属于开源模型的「小米时刻」,要来了。

MiMo-V2-Flash模型:https://huggingface.co/XiaomiMiMo/MiMo-V2-Flash

技术报告:https://github.com/XiaomiMiMo/MiMo-V2-Flash/blob/main/paper.pdf

AI Studio 体验地址:http://aistudio.xiaomimimo.com